U heeft ongetwijfeld de term GPT3 al zien voorbijkomen. Het lijkt alsof we nu eindelijk zijn gaan beseffen dat AI tot heel diep in het leven doordringt. Maar wat is GPT-3 en welke uitdagingen brengt het met zich mee? In deze blog wil ik stilstaan bij wat GPT-3 is en bij één van de educatieve uitdagingen die het model ons brengt.

Wat is GPT-3?

GPT-3 is een taalverwerkingsmodel. De meeste mensen kennen vooral AI-modellen die op beeldverwerking gebaseerd zijn, zoals gezichtsherkenning. In beide gevallen gaat het op een machine learning model dat getraind wordt aan de hand van enorme hoeveelheden data. Het getrainde algoritme kan dan als output allerlei soorten tekst, van poëzie tot essays tot codetaal genereren. Dergelijke tekst vraagt een hoog niveau van taalontwikkeling. De teksten die worden gegenereerd zijn coherent en grammaticaal correct. Het is dan ook niet gemakkelijk om het onderscheid te maken tussen een tekst die door het model werd gegenereerd en een tekst die door een mens werd geschreven.

Op zich kan de ontwikkeling dus best wel spectaculair genoemd worden, al is ze eigenlijk niet nieuw. Reeds geruime tijd zijn er heel wat toepassingen beschikbaar die ons ondersteunen in het omgaan met tekst. Een bekend voorbeeld is Deepl die er in slaagt om vertalingen van een goed tekstuele kwaliteit af te leveren.

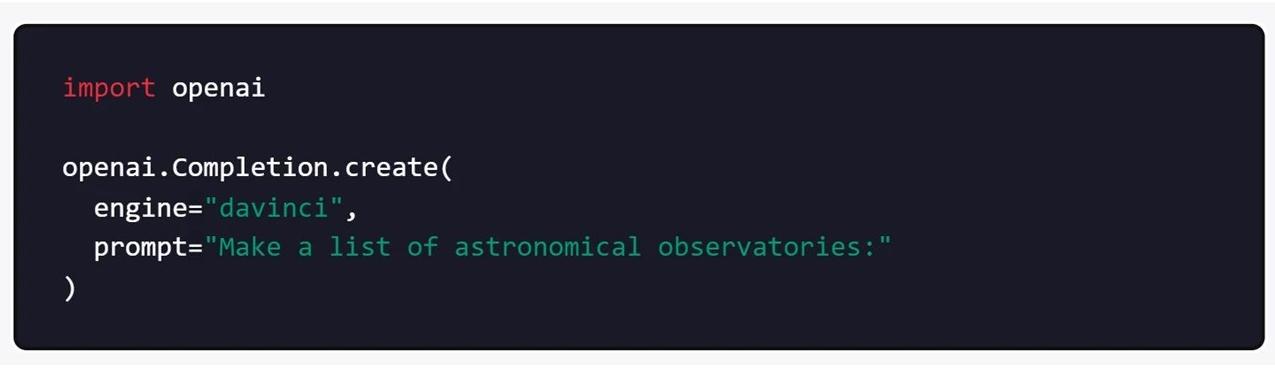

GPT3 bouwt dan ook voort op ontwikkelingen van de voorbije jaren, al dient gezegd dat de kwaliteit van de output sterk verbeterd is ten opzichte van vorige versies. Waar GPT2 getraind is op 1,5 miljard parameters, werd GTP3 getraind op 175 miljard parameters. Bovendien heeft OpenAI, het bedrijf dat het model heeft ontwikkeld, het beschikbaar gemaakt voor het ruimere publiek. Dat betekent dat iedereen die tekst wil genereren gebruik kan maken van het model. Dat kan gaan van scholieren, tot marketeers, tot ontwikkelaars van spam en malware, tot programmeurs in het algemeen.

De uitdaging

De vernieuwde technologie brengt echter nieuwe uitdagingen met zich mee. Die situeren zich op heel wat domeinen. Enkele voorbeelden: als het model gebruikt wordt om spammail te genereren, dan krijgen spamfilters steeds meer moeite om spam uit de mailbox te filteren. Als veel content op sociale media vooral automatisch gegenereerd wordt en dan via algoritmes ook nog geliket, dan is er de mogelijkheid dat de aangeboden content van sociale media radicaal verandert.

Het is onmogelijk om hier een overzicht te geven van alle mogelijke uitdagingen die de GPT3 met zich meebrengt. Ik wil mij dan ook beperken tot één van de educatieve uitdagingen die de algemene beschikbaarheid van het model met zich meebrengt. Studenten kunnen het model essays laten schrijven, poëzie laten genereren… Dat lijkt de ergste nachtmerrie te zijn voor een leerkracht of docent die zijn studenten kritisch wil leren nadenken en een taalkundig correcte tekst wil leren schrijven. Een andere aanpak dringt zich op.

Kritische noot vanuit de manier waarop AI wordt ontwikkeld

Wie notie heeft van hoe een AI-model wordt getraind en hoe output wordt gegenereerd, kan onmiddellijk enkele kritische bedenkingen maken.

1) We focussen ons even op de data waarmee het model wordt getraind. De data die gebruikt worden zijn voor de GPT-3 negentig procent Engelstalig. Dat betekent dat de output ook eerder beperkt zal zijn. Er wordt immers heel weinig van inhoud meegenomen uit andere taalgebieden.

De output is ook op andere manieren onmiddellijk verbonden met de data waarop het model is getraind. De internetdata die worden gebruikt bevatten vele vormen van bias, om er maar enkele te noemen: politieke bias, discriminatie ten opzicht van bepaalde doelgroepen… Deze bias wordt gemakkelijk gereproduceerd in de output. In eenvoudigere taal geformuleerd: wat veel voorkomt wordt versterkt.

Enkele voorbeelden:

- Het systeem kent geen mannelijke verpleegkundigen, omdat het aantal mannelijke verpleegkundigen procentueel veel kleiner is dan het aantal vrouwelijke verpleegkundigen. Dit voorbeeld doet denken aan de gekende Amazon-casus waarin de training van een algoritme op de bestaande HR-data leidde tot discriminatie van vrouwen bij aanwerving.

- Het systeem beperkt zich tot de content die reeds beschikbaar is op het ruimere net en vaak ook tot wat mainstream is. Nieuwe kennis is echter vaak net niet mainstream en valt dan ook vaak uit de boot in de output.

2) Het model ‘snapt’ ook niet echt de inhoud van wat het produceert. Een deep learning model zoals GPT-3 wordt gevoed met miljarden pagina’s tekst. Daar behoort bijvoorbeeld het geheel van alle pagina’s van Wikepedia bij, maar ook heel wat andere tekst die via het internet beschikbaar is. Eigen aan een deep learning model is dat er geen human oversight is, in de zin dat er niemand is die aangeeft of het model al dan niet klopt. Het model zoekt vooral verbanden. Je zou kunnen stellen dat de samenhang (coherence) dan ook sterk prevaleert op de nauwkeurigheid van de inhoud. Anders verwoord: GPT-3 is geen inhoudelijk expert.

Dat merk je als je bijvoorbeeld het curriculum van personen wil genereren. Ik probeerde even met het genereren van mijn eigen CV. Een eerste resultaat gaf aan dat ik een publisher was van educatieve boeken. Het klopt dat er een grote uitgeverij is die Folens heet, maar het leek me moeilijk om die met mijn voornaam te linken.

In een tweede poging voegde ik KULeuven en VIVES toe, in een poging om het systeem een bepaalde richting op te sturen. Daar kwam ik eruit als een doctor in de computerwetenschappen die aan de VUB en aan de KULeuven heeft gestudeerd. Geen van beide outputs draagt ook maar iets van correctheid in zich.

3) Een laatste element is het element van creativiteit. Dat het model geen creativiteit kent, zoals in vele commentaren wordt beweerd, klopt volgens mij niet. Creativiteit bestaat er ook in om bestaande gegevens op een nieuwe manier samen te leggen. Dat is een vorm van creativiteit die mogelijk is. Wat het model echter niet doet is via kritische reflectie tot nieuwe inzichten komen. Dat is iets wat in die zin zeer belangrijk is om toe te voegen in het omgaan met de GPT-3.

Een vernieuwde aanpak

De grootste uitdaging voor het onderwijs ligt dus in het kritisch omgaan met de gegenereerde teksten. Het heeft weinig zin om nieuwe technologieën als deze uit het onderwijs te bannen. Het is nu eenmaal eigen aan onze tijd dat er andere manieren om met informatie om te gaan ontstaan. Dat laatste is fundamenteel veranderd sinds de komst van het internet en de hoeveelheid content en informatie blijft maar groeien. De grote uitdaging is om de informatie op haar waarde te kunnen beoordelen.

Zoals hierboven kort werd geïllustreerd kan een beperkte kennis van de manier waarop AI-modellen worden getraind een kritische manier van omgaan ermee bevorderen. Daar zit voor mij de grootste uitdaging.

De criteria verschillen daarbij niet zo sterk van de onderzoeksvaardigheden die we in het onderwijs hebben ingebed: (1) Het kijken naar de oorsprong van de bronnen die je gebruikt. Hier behelst dit het kijken naar de data van waaruit de tekst werd gegenereerd. (2) Het kijken naar de methodologie. Daar sluit het kritisch omgaan en verdiepen van de gegenereerde kennis bij aan.